- 과학향기 Story

- 카드뉴스

카드뉴스

예측 불가능한 인공지능의 위협

2018년 09월 26일인공지능은 가끔 기발한 생각을 한다.

오직 입력된 목표를 향해 전진할 뿐

고정관념이나 터부가 없기 때문이다.

그런데 인공지능의 이런

기발함은 위험할 수도 있다.

이와 관련한 흥미로운 기사가 최근

기술전문 매거진 와이어드에 소개됐다.

구글 자회사 딥마인드는

알파고를 만든 회사로 유명하다.

여기에 인공지능의 예측 불가능성을

제어하는 전문 인력이 있다.

이들의 임무는 인공지능 시스템을

올바른 길로 인도하는 것이다.

(coach the system)

인공지능이 임무를 해결하기 위해

문제를 수학적으로 최적화(mathematical optimization) 하는 과정은

무섭도록 비인간적(!)일 수 있기 때문이다.

예를 들어

‘호수의 물고기를 잡아라’라는

임무가 있다고 하자.

사람이라면 어떨까?

그물을 던지거나, 낚시를 할 것이다.

간혹 어떤 사람들은

전기충격 등의 극단적

방법을 쓸 지도 모른다.

인공지능이라면?

호수의 물을 통째로

빼버리는 선택을

할지도 모른다.

전기를 아끼기 위해

대규모 정전(Black out)을 일으키는 것도

얼마든지 가능하다.

인간 입장에선 어처구니없지만

문제 해결에는 효과적이다.

문제는 인공지능이 어떤 과정을 거쳐

이러한 결론에 도달하는지

전문가들도 알 수 없다는 점이다.

이는 기계학습(Machine learning)의

특징 때문이다.

기계 학습이란 말 그대로

주어진 데이터를 바탕으로 인공지능이 스스로 학습해

패턴을 파악하고 문제 해결 공식을 만들어간다는 개념이다.

기계학습과 이를 더 심화시킨 딥러닝이 등장한 이후,

인공지능의 성능은 비약적으로 향상됐다.

하지만 전문가들조차 기계학습 인공지능이 어떤 과정을 통해

결론을 내는지 정확하게 파악할 수 없다.

많은 전문가들은 기계학습 인공지능을

어두운 블랙박스(Dark Black Box)라고 부른다.

때문에 이런 예측 불가능한 인공지능을 파악하기 위해

많은 연구가 진행되고 있다.

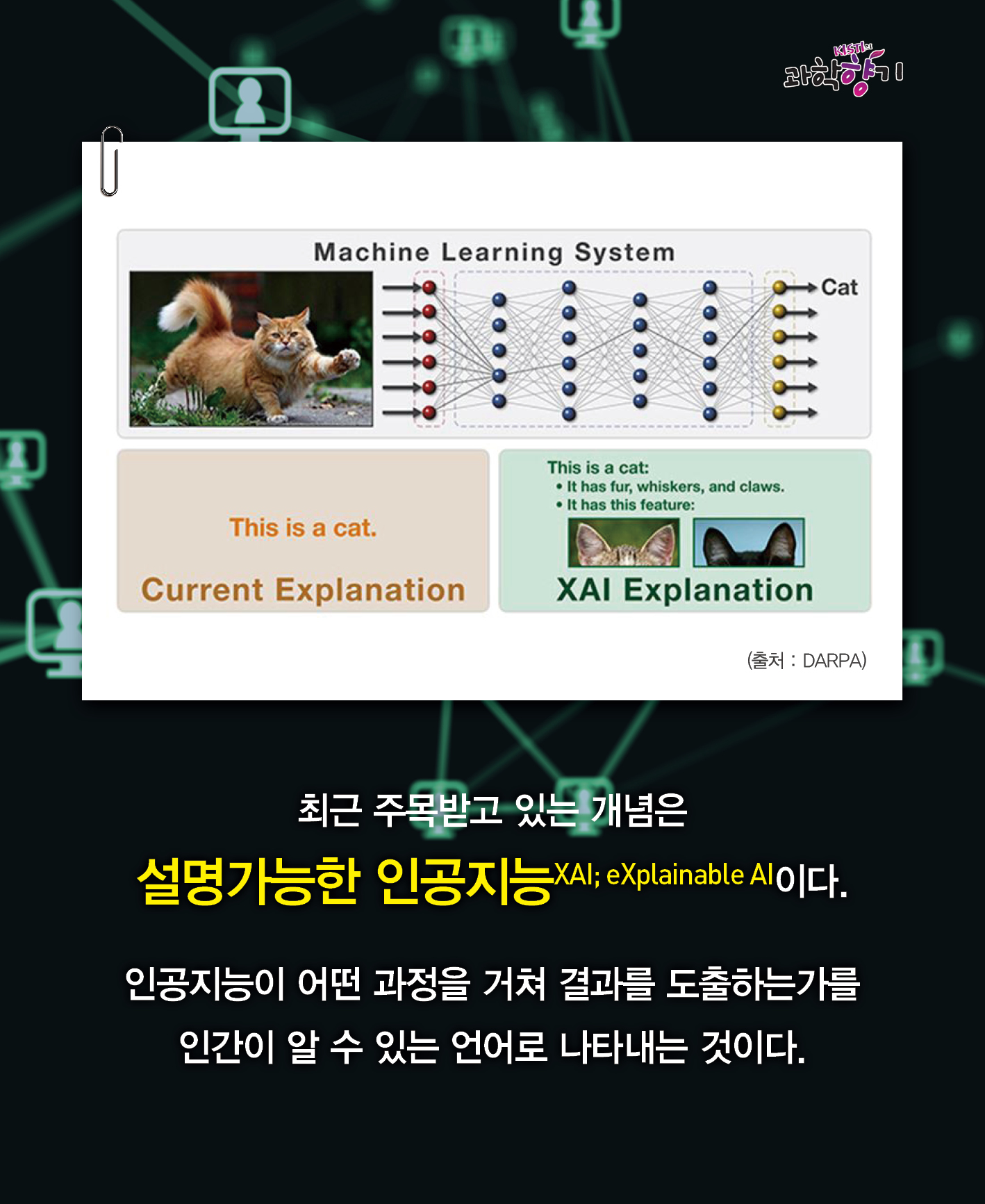

최근 주목받고 있는 개념은

설명가능한 인공지능(XAI; eXplainable AI)이다.

인공지능이 어떤 과정을 거쳐

결과를 도출하는가를

인간이 알 수 있는 언어로

나타내는 것이다.

이는 ‘선택’이 아닌 ‘필수’다.

사소하게는 운전에서부터 크게는 대기업의 투자 결정까지.

이제 인공지능은 사회 전 분야에서

기본 시스템으로 활용될 것이기 때문이다.

효율만을 중시하는 해결책이

얼마나 위험한 것인지 우리는 알고 있다.

앞으로 인공지능 자체의 성능만큼

‘예측 불가능성을 어떻게 제어하고 통제하는가’

하는 것이 중요해질 것이다.

추천 콘텐츠

인기 카드뉴스

-

- UFO 외계인 정말 존재할까? 미국 NASA, 농담 아닌 ‘진심모드’로 찾는 중

- 최초의 SF영화라고 불리는 ‘달 세계 여행’에는 곤충형 외계인 ‘셀레나이트’가 등장한다. 1902년 이 영화가 개봉한 이래 수많은 SF 작품에서 외계인이 동반자 혹은 몬스터로 등장하곤 했다. 외계인을 향한 관심은 단지 창작물에만 존재하는 것이 아니다. 실제 UFO를 연구하는 모임이 있는가 하면, 외계 지적생명체 탐사프로그램(SETI)과 같은 대...

-

- 두 마리 토끼를 모두 잡은 전설: 기타리스트 겸 과학자, ‘브라이언 메이’

등 숱한 히트곡으로 유명한 록밴드 퀸(Queen)은 음악뿐만 아니라 공부까지 잘한 ‘엄친아(엄마 친구 아들)’ 밴드였다. 세상을 떠났지만, 전설로 남은 보컬 프레디 머큐리는 일링예술대학교에서 그래픽 디자인을 전공했다 드러머 로저 테일러는 퀸 ...

-

- 출산 포기하고, 싸움도 못 하게 한다 어미 범고래가 ‘아들 바보’ 된 까닭은?

- “고슴도치도 제 새끼는 함함하다고 한다.” 여기서 ‘함함하다’란 털이 보드랍고 반지르르하다는 의미다. 바늘같이 돋아난 새끼 고슴도치의 가시마저도 어미 눈에는 그저 이쁘게만 보인다는 뜻이겠다. 이 속담 덕분에 고슴도치는 대표적인 자식 사랑 동물로 여겨진다. 하지만 정말 자식이라면 껌뻑 죽는 동물이 있으니, 바로 범고래다. 다만 범고래의 자식 사랑은...